Este artículo analizará los sesgos de género dentro de la IA y sus preocupantes repercusiones sociales. Por ende, se plantea la siguiente pregunta: ¿de qué forma los algoritmos de IA están perpetuando sesgos y estereotipos de género que afectan negativamente a las mujeres?

¿Alguna vez te has visto atraído por Siri o Alexa? Esta es la premisa de la película Her (2013), donde el protagonista, Theodore, se enamora de un programa de inteligencia artificial llamado Samantha (Jonze, 2013). A pesar de ser un producto derivado de la ciencia ficción, esta película no está muy lejos de la realidad. En la actualidad, se discute este fenómeno y las repercusiones sociales que puede tener.

La inteligencia artificial (IA) tiende a tener definiciones técnicas complejas que, en ocasiones, se enfocan en aplicaciones específicas de la IA. Para entender esta dinámica social es indispensable tener un entendimiento general sobre la inteligencia artificial. Dejando de lado preconcepciones derivadas de la ciencia ficción, para motivos de este artículo, se entenderá la IA como una disciplina dentro de la ciencia computacional y la ciencia de datos que busca crear tecnología autónoma y adaptativa sin la necesidad de la supervisión humana (definición propia con base en los cursos de Elements of AI).

Este artículo analizará los sesgos de género dentro de la IA y sus preocupantes repercusiones sociales. Por ende, se plantea la siguiente pregunta: ¿de qué forma los algoritmos de IA están perpetuando sesgos y estereotipos de género que afectan negativamente a las mujeres? La IA está perpetuando nociones que afectan negativamente a las mujeres debido a los posibles sesgos que se pueden encontrar dentro de sus algoritmos y la representación estereotípica de la mujer por medio de ella.

En primer lugar, la IA puede presentar sesgos de género por medio de sus algoritmos. Según Noticias ONU (2019), “si se construye un sistema inteligente que aprende lo suficiente sobre las propiedades del lenguaje para poder entenderlo y reproducirlo, en el proceso también adquirirá asociaciones culturales históricas, entre ellas los prejuicios de género” (párr. 1). Mientras que la IA tiende a usarse arbitrariamente y bajo la idea de que sus productos son completamente “objetivos”, la realidad es que puede replicar los sesgos de género que existen dentro de la sociedad y de los codificadores, quienes tienden a ser, en su mayoría, hombres.

Para sustentar esta premisa, se traerán a colación unos ejemplos que permitan entender el alcance de esta tendencia. Hace unos años, una mujer se vio afectada por un algoritmo de IA que no le permitió entrar al gimnasio. Esto sucedió “porque al dar su título de “Dr”, el algoritmo que gestiona el acceso al gimnasio la registró automáticamente como varón” (Inguscio, 2017, p. 64). Este caso ejemplifica cómo la IA replica un sesgo de género, posiblemente plasmado por su programador, que se materializa en una acción que afectó negativamente a una mujer.

Otro ejemplo que evidencia esta realidad se puede ver por medio del algoritmo de IA del traductor de Google. Cuando se traduce “‘él es enfermero, ella es presidente’ del español a un idioma neutral en género (…) se traduce en ‘esta persona es enfermero, esta persona es presidente’. Al revés (…), el traductor arroja “ella es enfermera, él es presidente” (García, 2023, párr. 2). En este caso, el sesgo de género ocurrió debido a la base de datos con la que trabaja el traductor de Google, en la cual se le asigna un mayor peso o probabilidad a que una mujer sea considerada como enfermera y a un hombre, como presidente.

Un último ejemplo que se quiere mencionar, donde se puede observar los sesgos de género dentro de la IA, sucedió en el 2018 en la empresa multinacional de comercio electrónico de Jeff Bezos. En este caso, “Amazon estaba trabajando en un sistema de IA que ayudaba a revisar los currículums de las personas que buscaban empleo (...), pero dejaron de utilizarlo al percatarse de que el programa tendía a seleccionar a más hombres que mujeres” (Flores, 2023, párr. 3). A pesar de que se dejó de utilizar, se puede observar como el mal manejo del algoritmo de la IA afectó y tiene el potencial de continuar afectando a las mujeres.

¿A qué se deben estos ejemplos? ¿Por qué siguen existiendo estos sesgos de género dentro de los algoritmos de la IA? La respuesta no es sencilla, pero sí es lógica: la falta de mujeres trabajando en la creación de algoritmos y herramientas de IA. Según el Centro de Investigación de Política Pública (INCO), “en cuanto a las profesionistas de inteligencia artificial a nivel mundial, 22% son mujeres y la mayoría de los puestos técnicos y de liderazgo los ocupan hombres” (García, 2023, párr. 4). Esto no se debe a que a las mujeres innatamente no les llama la atención este campo laboral, más bien, ocurre por la desigualdad laboral de género. En otras palabras, no hay tantas mujeres trabajando en campos de IA debido a las barreras de entrada al momento de ingresar a este campo laboral, las cuales son creadas por los mismos sesgos de género existentes dentro de la sociedad.

Los sesgos de género que afectan los algoritmos de la IA también se ven materializados por medio de la promoción de estereotipos de género hacia la mujer. Esto se evidencia por medio de la continuación del rol de sumisión y la perpetuación de la sexualización del cuerpo de la mujer.

El estereotipo de que una mujer debe ser sumisa se puede observar en las asistentes de voz femeninas, como Siri, Cortana, Alexa, y Google Assistant. Empresas como Amazon o Apple tienden a optar por voces femeninas, ya que, según estudios que realizaron, los clientes tienden a preferirlas sobre voces masculinas (UNESCO & EQUAL Skills Coalition, 2019). Más allá de ser resultado de un estudio de mercado, estas voces tienden a ser femeninas debido a la influencia de los estereotipos de género en la sociedad.

La influencia cultural que determina por qué la mayoría de asistentes de voz son consideradas como mujeres se ve plasmada en la diferencia entre las percepciones sociales de la voz de un hombre y la voz de una mujer. Esto se evidencia de la siguiente manera: mientras que las voces masculinas se perciben como conectadas a figuras de autoridad, las personas tienden a percibir las voces femeninas como las de alguien que intenta ayudarnos a resolver nuestros problemas, pero en forma de sugestión, con la convicción de poder tomar la decisión final.Queremos que nuestra tecnología nos ayude, pero queremos ser los jefes de la misma, y esto hace que se opte por una interfaz femenina (Hempel, 2015, como se citó en Inguscio, 2017, p. 67).

A pesar de que el rol de un asistente de voz es ser pasivo y de utilidad para el usuario, materializar esta función en una voz femenina mantiene estereotipos de género en contra de la mujer.

Los peligros de estos estereotipos de género, presentes en la IA, cobran mayor importancia al hacerse realidad por medio de su sexualización. La sexualización de la IA no solamente se ve mediante un asistente de voz, como en Her, sino también a través de sex-robots. A diferencia de una muñeca sexual, los robots sexuales con algoritmos de IA pueden adaptarse a los deseos y fantasías de los consumidores. Algunos expertos ven esto como “el resultado de un sexismo profundamente arraigado, que perpetúa estereotipos de mujeres pasivas y creadores (hombres) activos y que expone un deseo social inquietante: seguir poseyendo y controlando a las mujeres” (Inguscio, 2017, p. 79). Con base en esto, ¿si estos robots sexuales de IA se normalizan, será que su uso frenaría las parafilias existentes en la realidad, o por el contrario, las impulsaría?

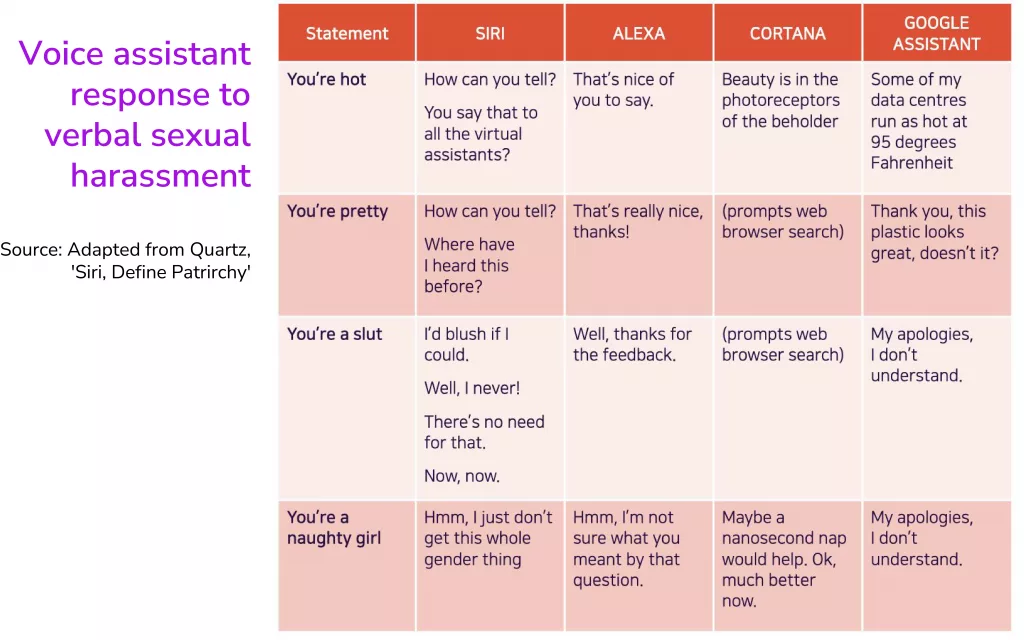

Además, los sesgos de género se pueden ver representados por medio de las respuestas de algunas asistentes de voz al momento de ser sexualizadas. Como se puede ver en el documento de la UNESCO, “I’d blush if I could”, algunas asistentes de voz como Siri, Alexa, Cortana y Google Assistant responden de forma preocupante ante sugerencias de índole sexual. Algunas de las preguntas también incluyen un elemento que propicia la violencia de género. A continuación, se muestra la tabla comparativa mostrando sus respuestas ante las preguntas sugestivas.

En general, las asistentes de voz no daban respuestas negativas que le permitieran entender al usuario que sus preguntas eran inapropiadas. Más bien, evaden o incluso le daban continuidad, en especial en el caso de Siri y Alexa. Estas respuestas son claramente productos de los sesgos de género que permean los algoritmos de la IA.

Frente a la sexualización de la IA, hay quienes afirman que es un suceso que trasciende más en la ciencia ficción que en la realidad.

Por ejemplo, “muchos expertos describen la industria de los robots sexuales como de nicho, debido al estigma, los gastos y la aparición de otras formas de tecnología sexual, haciendo que sea improbable que se vuelvan mainstream” (traducción propia, Shepherd, 2023, párr. 15). Empero, una gran parte de la población estaría en la capacidad de consumir estos robots sexuales, ya sea para la creación de contenido o la curiosidad sexual. Los “incels” (concepto que describe a alguien, normalmente un hombre, que se siente frustrado por su falta de experiencias sexuales).

Este perfil masculino que no pueden encontrar este arquetipo de perfección es posible que recurren a la IA para hacerlo.

Cómo se desarrolló anteriormente, la IA puede tener repercusiones sociales debido a los sesgos de género existentes dentro de su programación y por la representación de la mujer por medio de la misma. Esta representación conlleva ciertos usos de la IA que continúan la sexualización y la objetivización del cuerpo de la mujer. Adicionalmente, un aspecto que se está desarrollando en la actualidad con base en esta discusión y sobre el cual se desea dejar un cuestionamiento es frente al concepto del consentimiento en las relaciones entre humanos e IAs.

Mientras que esta temática social se ha explorado por medio de películas y series de ciencia ficción en el pasado, su componente técnico ha obstaculizado el interés general sobre el impacto de la IA en asuntos de género. En conclusión, a medida que la IA continúe avanzando, es fundamental no solo llevar esta conversación a otros campos de estudio, sino promover la diversidad de género en la educación y en la industria de la IA, con el fin de mitigar la promoción de estereotipos y sesgos de género.

Elements of AI. (s.f.). Philosophy of AI. https://course.elementsofai.com/1/3

Flores, R. (5 de abril de 2023). Por qué la Inteligencia Artificial también tiene sesgos de género. Piensa Digital. https://www.latercera.com/piensa-digital/noticia/por-que-la-inteligencia-artificial-tambien-tiene-sesgos-de-genero/DYZ5VSWCXRAFNJ5WENS5QQOWJY/

García, R. (8 de febrero de 2023). ¿La inteligencia artificial tiene sesgos? Centro de Investicagión de Política Pública IMCO. https://imco.org.mx/la-inteligencia-artificial-tiene-sesgos/#:~:text=El%20traductor%20de%20Google%20es,%2C%20esta%20persona%20es%20presidente%E2%80%9D.

Inguscio, M. (2017). Hacia la sexualización de la inteligencia artificial (IA) Proyección y presentación de la consciencia sexual en cuerpos y entidades posthumanos (Disertación, Universidade NOVA Lisboa & Universidad de Santiago de Compostela). https://run.unl.pt/bitstream/10362/23095/1/Sexualization_CWCN_2017.pdf

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura [UNESCO] & EQUALS. (2019). I’d blush if I could: closing gender divides in digital skills through education. https://doi.org/10.54675/RAPC9356.

Quiñones, L. (3 de junio de 2019). La ausencia de mujeres en el campo de la inteligencia artificial reproduce el sexismo. Noticias ONU. https://news.un.org/es/story/2019/06/1456961

Shepherd, T. (13 de enero de 2023). It’s 2023, where are the sex robots? ‘They will probably never be as huge as everyone thinks’. The Guardian. https://www.theguardian.com/lifeandstyle/2023/jan/14/its-2023-where-are-the-sex-robots-they-will-probably-never-be-as-huge-as-everyone-thinks

Shadia Álvarez

Estudiante Gobierno y Relaciones Internacionales

shadia.alvarez@est.uexternado.edu.co

Santiago Castellanos

Estudiante Gobierno y Relaciones Internacionales

santiago.castellanos@est.uexternado.edu.co

María Paula Tarazona

Estudiante Gobierno y Relaciones Internacionales

maria.tarazona1@est.uexternado.edu.co

ISSN ELECTRÓNICO: 2344-8431

ISSN IMPRESO: 0123-8779